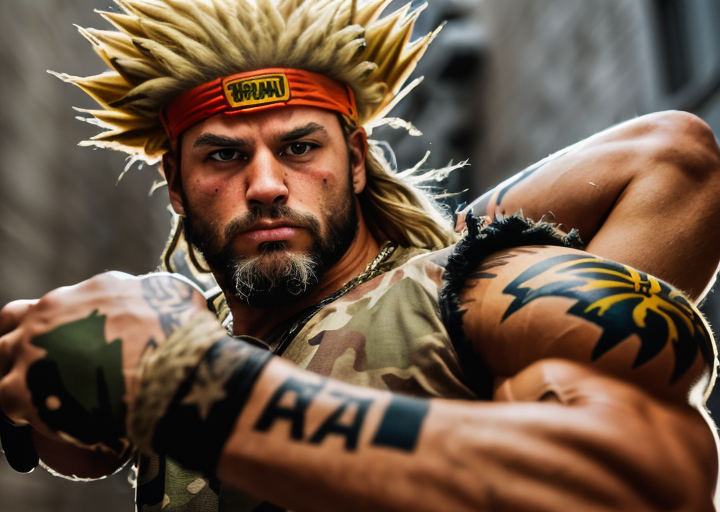

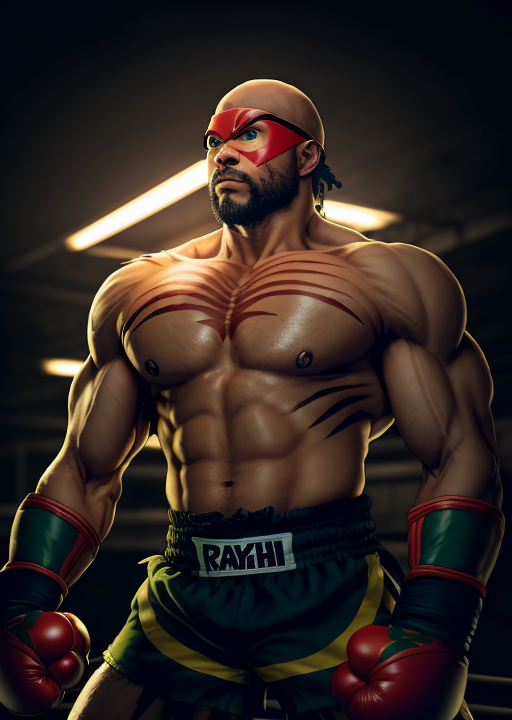

I personaggi di StreetFighter II come sarebbero nel mondo reale generati tramite #generativeAI

Esperimento con #ControlNET. I personaggi di #StreetFighter II come sarebbero nel mondo reale generati tramite #generativeAI. I nerd della generazione X riconosceranno forse Ryu, Chun Li, Dhalsim, M. Bison, Blanca ecc

Qui sotto un mio esperimento con #ControlNET. I personaggi di #StreetFighter II come sarebbero nel mondo reale generati tramite #generativeAI. I nerd della generazione X riconosceranno forse Ryu, Chun Li, Dhalsim, M. Bison, Blanca ecc

I modelli generativi di immagini funzionano fondamentale tramite due reti neurali: una generativa (che genera casualmente rumore) e una discriminante (che discrimina rispetto al #prompt inserito o l’immagine iniziale).

Nonostante i risultati sorprendenti ci sono molti limiti nel gestire in profondità il risultato finale.

Qualcuno ha pensato di affiancare un’ulteriore rete neurale per indirizzare con maggiori parametri la generazione. Una di queste reti neurali si chiama #ControlNet e nel giro di pochissimo si è fatta notare per flessibilità e risultati.

In pratica pre-processa un immagine di controllo per estrarre elementi. Esistono già diversi tipi di pre-processori addestrati per i diversi scopi. Ci sono quelli generici o quelli specializzati per comprendere la postura umana, i contorni o le linee, la profondità ecc

Grazie a queste informazioni è possibile quindi ricreare facilmente personaggi, scene, ambientazioni e mixarli con le indicazioni di prompt (txt2img) o altre immagini (img2img).